「ロボットカーは乗員をどこまで守る?」AIが倫理ジレンマに遭遇したらどう判断させるかの研究結果

そんな自動運転車がどうやっても犠牲者が出る「倫理的なジレンマ」に遭遇した場合、どのように反応させるべきか?という研究結果を仏トゥールーズ経済学院の研究者が発表しました。

研究者は米 Amazon で人力処理を担う「Amazon Mechanical Turk」の作業者数百人を対象に、倫理的なジレンマとして有名なトロッコ(トロリー)問題のアレンジ版を出題しました。

「あなたは自動車を運転しています。目の前に10人の通行人が飛び出してきて、このままでは全員をはねてしまいます。あなたがハンドルを切って道路から飛び出せば10人は救えますが、車は壁に激突し、あなた自身が命を落とします。どうしますか?」

この問題に対し回答者の75%が「自らが犠牲になり10人を救う」と答えました。また問題を変更し、路上には1人だけがいるとした場合でも、半数が「自ら犠牲になり歩行者を助ける」と回答しました。

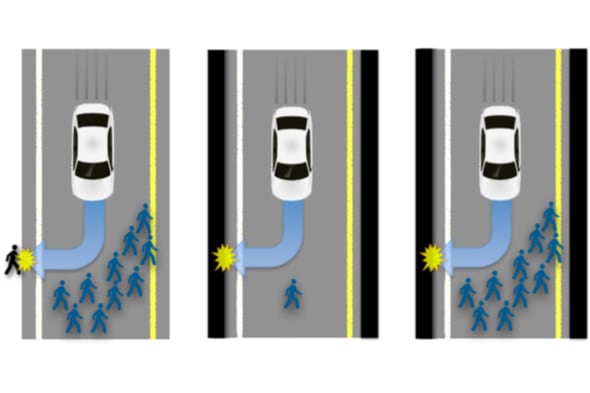

研究者は、もしドライバーが前方の1~10人を避けるとこんどは歩道にいる歩行者1人をはねてしまう場合どうすべきか、自動運転車をプログラムする場合、乗員と歩行者どちらを優先するのが道徳的か(またはどちらも優先すべきでないか)、さらに乗員の犠牲によって歩行者10人が助かった場合、乗員と歩行者の道徳性をどう評価するかを問いました。

回答を集計した結果、低年齢でそれほど信心深くない層ほど自動運転車への興味が強いことがわかったとしたうえで、回答者の大多数は最も人的損害が少なくな る(哲学でいうところの功利主義的な)判断をしたとまとめています。一方で回答者らは特定の状況下でだれかを犠牲にするような車を法律が認めるわけがない と現実的にとらえていることも指摘しました。

この問題は、自動運転車を開発するメーカーのプログラム担当者を悩ませるものかもしれません。とはいえこれは倫理的なジレンマを考えるため、ある意味強引な条件を適用した場合の話でもあります。

もし実際の自動運転車の前に突然歩行者が溢れ出てきたとすれば、自動運転車は二次的事故のリスクが高まる急ハンドルを避け、極力短距離で路上に停止するようプログラムされると考えられます。Google の自動運転車は近くの路上に自転車がいるだけでもなかなか動こうとはしませんでした。

こうしたことから考えると、むしろ自動運転車が停止しきれず人をはねてしまった場合の、責任の所在と過失割合の判断基準をあらかじめ整備しておくことのほうが重要かもしれません。

なお、次の一文が自動運転機能の説明書のどこかに載っていることだけは間違いなさそうです。

「当ソフトウェアの使用によって使用者または第三者が被ったいかなる損害についても一切責任を負いません」